??????? 美國GPU服務器在選擇配置時,需綜合考慮應用場景、預算、性能需求及擴展性,本文小編就來分享一套美國GPU服務器詳細的配置選擇步驟,涵蓋硬件選型、網絡優化、存儲配置及操作命令,以幫助美國GPU服務器用戶們精準匹配業務需求。

??????? 一、明確應用場景與需求

??????? 1、場景分類?

??????? - AI訓練與推理:需要美國GPU服務器高算力(如NVIDIA A100/H100)、大顯存(≥40GB)及多卡并行能力。

??????? - 圖形渲染與建模:依賴OpenGL/CUDA優化的顯卡(如NVIDIA RTX A6000)及高速存儲(NVMe SSD)。

??????? - 科學計算與模擬:強調CPU與GPU的協同(如AMD EPYC + NVIDIA A100),需美國GPU服務器高內存(≥512GB)和PCIe/NVLink互聯。

??????? - 視頻處理與轉碼:適合中端GPU(如Tesla T4)和大容量存儲(HDD/SSD混合)。

??????? 2、需求評估?

??????? - 計算復雜度:根據美國GPU服務器業務模型規模或渲染精度確定GPU數量。

??????? - 數據吞吐量:選擇高帶寬網絡(InfiniBand/100GbE)和低延遲存儲(RAID NVMe)。

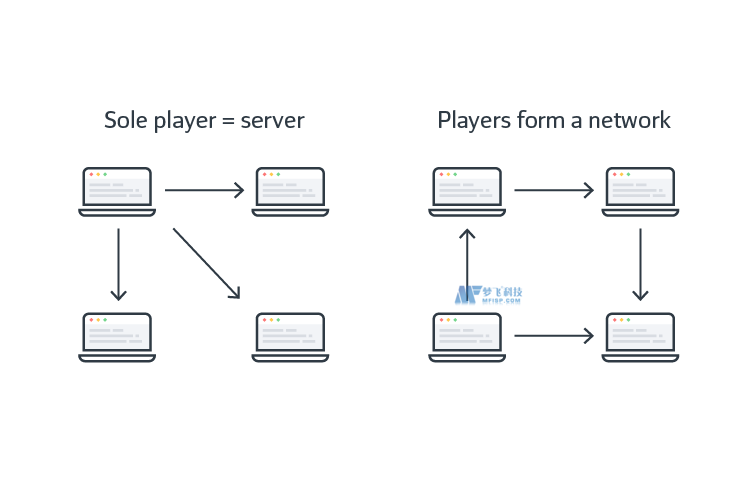

??????? - 并發任務:多臺美國GPU服務器需支持NVLink或PCIe Gen4.0以上互聯技術。

??????? 二、硬件配置選擇

??????? 1、GPU型號與數量?

??????? - 入門級:單卡美國GPU服務器如NVIDIA Tesla T4/RTX 3090,適合小型AI模型或輕量渲染。

??????? - 中端:2-4卡如RTX A6000/A100,滿足中型深度學習或團隊協作渲染。

??????? - 旗艦級:8卡及以上如NVIDIA H100,用于美國GPU服務器大規模分布式訓練或工業級渲染。

# 示例:查詢可用GPU型號(以AWS為例) aws ec2 describe-instance-types --filter Name=gpu,Values="NVIDIA:A100*"

??????? 2、CPU與內存?

??????? - CPU:選擇多核高頻型號(如AMD EPYC 9654/Intel Xeon Gold),確保美國GPU服務器數據預處理和調度能力。

??????? - 內存:根據美國GPU服務器數據集大小配置,AI訓練建議≥256GB DDR5 ECC,科學計算需≥512GB。

??????? 3、存儲與網絡?

??????? - 存儲:

系統盤:NVMe SSD(≥1TB,讀寫速度≥3GB/s)。 數據盤:企業級HDD(高容量)或RAID陣列。 網絡:優先選擇InfiniBand(低延遲)或100GbE帶寬,支持RDMA加速。

??????? 三、配置操作步驟

??????? - AWS:使用p3/p4/g5實例(如p4d.24xlarge含8個A100 GPU)。

??????? - Azure:選擇NC系列(如Standard_NC24as_T4含4個A100)。

??????? - RAKsmart:按需定制美國GPU服務器CPU、內存、存儲(參考價格具體見官網)。

# AWS示例:啟動帶8塊A100的實例 aws ec2 run-instances --instance-type p4d.24xlarge --gpu-count 8 --block-duration-minutes 60

??????? 2、安裝驅動與工具?

??????? - NVIDIA驅動:確保與美國GPU服務器的GPU型號匹配(如A100需CUDA 12+)。

??????? - CUDA Toolkit:通過包管理器安裝(Ubuntu示例如下)。

??????? - Deep Learning框架:安裝PyTorch/TensorFlow并啟用美國GPU服務器GPU支持。

# Ubuntu系統安裝NVIDIA驅動 sudo apt update sudo apt install nvidia-driver-531 # 安裝CUDA Toolkit sudo apt install cuda-12-1 # 驗證GPU狀態 nvidia-smi

??????? 3、配置多GPU并行環境?

??????? - PyTorch示例:使用torch.nn.DataParallel或DistributedDataParallel實現美國GPU服務器多卡訓練。

??????? - TensorFlow示例:設置tf.distribute.MirroredStrategy策略。

# PyTorch多GPU訓練代碼片段 import torch import torch.nn as nn model = nn.DataParallel(model).cuda()? # 自動分配GPU output = model(input_data)

??????? 四、性能優化與監控

??????? 1、帶寬與延遲優化?

??????? - 使用nccl-tests工具測試美國GPU服務器多GPU通信效率,調整NVLink/PCIe參數。

??????? - 啟用RDMA(Remote Direct Memory Access)減少網絡開銷。

# 測試NCCL多GPU通信帶寬 sudo /usr/local/cuda/bin/nccl-tests/build/a.out -b -e ops -f tensor -n 2 -w 4

??????? 2、監控工具部署?

??????? - GPU監控:nvidia-smi實時查看美國GPU服務器顯存、溫度及功耗。

??????? - 系統監控:htop檢查美國GPU服務器CPU/內存占用,iostat分析存儲I/O瓶頸。

# 設置GPU監控腳本(每秒刷新一次) watch -n 1 nvidia-smi

五、成本控制與擴展性

??????? 1、按需擴容?

??????? - 優先選擇支持熱插拔的美國GPU服務器(如Supermicro SYS-420GP-TNAR+),便于后期添加GPU或硬盤。

??????? - 使用容器化(Docker + NVIDIA Container Toolkit)提升美國GPU服務器資源利用率。

??????? 2、預算分級推薦?

??????? - 入門級:單GPU(RTX A4500)+ 128GB內存 + 1TB NVMe。

??????? - 中端:4×RTX A6000 + 512GB內存 + RAID陣列。

??????? - 旗艦級:8×H100 + InfiniBand網絡 + 2TB DDR5內存。

??????? 選擇美國GPU服務器需從場景需求出發,平衡性能、帶寬與成本。通過明確GPU型號、優化存儲網絡、部署并行框架及監控工具,可顯著提升計算效率。無論是初創團隊還是企業級用戶,均可通過靈活配置美國GPU服務器,實現高性價比部署。最終,結合業務擴展性預留升級空間,方能長期保障算力需求。

??????? 現在夢飛科技合作的美國VM機房的美國服務器所有配置都免費贈送防御值 ,可以有效防護網站的安全,以下是部分配置介紹:

| CPU | 內存 | 硬盤 | 帶寬 | IP | 價格 | 防御 |

| E3-1270v2 四核 | 32GB | 500GB?SSD | 1G無限流量 | 1個IP | 320/月 | 免費贈送1800Gbps?DDoS防御 |

| Dual E5-2690v1 十六核 | 32GB | 500GB?SSD | 1G無限流量 | 1個IP | 820/月 | 免費贈送1800Gbps?DDoS防御 |

| AMD Ryzen 9900x 十二核 | 64GB | 1TB NVME | 1G無限流量 | 1個IP | 1250/月 | 免費贈送1800Gbps?DDoS防御 |

| Dual Intel Gold 6230 四十核 | 128GB | 960GB NVME | 1G無限流量 | 1個IP | 1530/月 | 免費贈送1800Gbps?DDoS防御 |

??????? 夢飛科技已與全球多個國家的頂級數據中心達成戰略合作關系,為互聯網外貿行業、金融行業、IOT行業、游戲行業、直播行業、電商行業等企業客戶等提供一站式安全解決方案。持續關注夢飛科技官網,獲取更多IDC資訊!